Dipl.-Ing. Julia Schachtschneider

Erstbetreuer: C. Brenner; Co-Betreuer: M. Sester

Im Kontext des autonomen Fahrens besteht starkes Interesse an hochgenauen und aktuellen Umgebungsmodellen. Da sich natürliche Umgebungen ständig verändern, besteht eine der größten Herausforderungen darin, diese Veränderungen zu erkennen und zu modellieren. Dabei kann es sich beispielsweise um permanente Änderungen, wie neue Gebäude oder Straßenbeläge handeln oder um zeitabhängige Effekte, welche unterschiedlichen Mustern folgen. Z.B. Vegetation, die sich periodisch mit den Jahreszeiten ändert oder parkende Fahrzeuge, die ihre Position in einem täglichen oder wöchentlichen Zyklus ändern. Ein häufiger Ansatz besteht darin, alle nicht statischen Teile der Umgebung aus der Karte zu entfernen. Dies hat den Nachteil, dass auch eine große Menge nützlicher Informationen verworfen wird.

In diesem Projekt arbeiten wir an der Entwicklung eines Umgebungsmodells, das zeitliche Effekte einbezieht. Wir wollen eine Karte entwickeln, die die dynamischen Prozesse einer urbanen Umgebung abbildet und eine probabilistische Beschreibung aller Objekte zu jedem Zeitpunkt enthält.

Wenn beispielsweise ein selbstfahrendes Auto eine rein statische Karte verwendet, würden alle Messungen von sich verändernden Objekten zu Konflikten mit der Karte führen. Außerdem könnten Gebiete mit nur wenigen statischen Komponenten eine sehr ungenaue Karte haben. Da unser Modell zeitliche Effekte berücksichtigt, werden Änderungen vom Roboter "erwartet". Darüber hinaus enthält die Karte in Gebieten mit nur wenigen statischen Objekten immer noch die veränderlichen Teile der Umgebung. Selbst wenn diese eine geringere Genauigkeit haben, ist eine grobe Lokalisierung immer noch möglich.

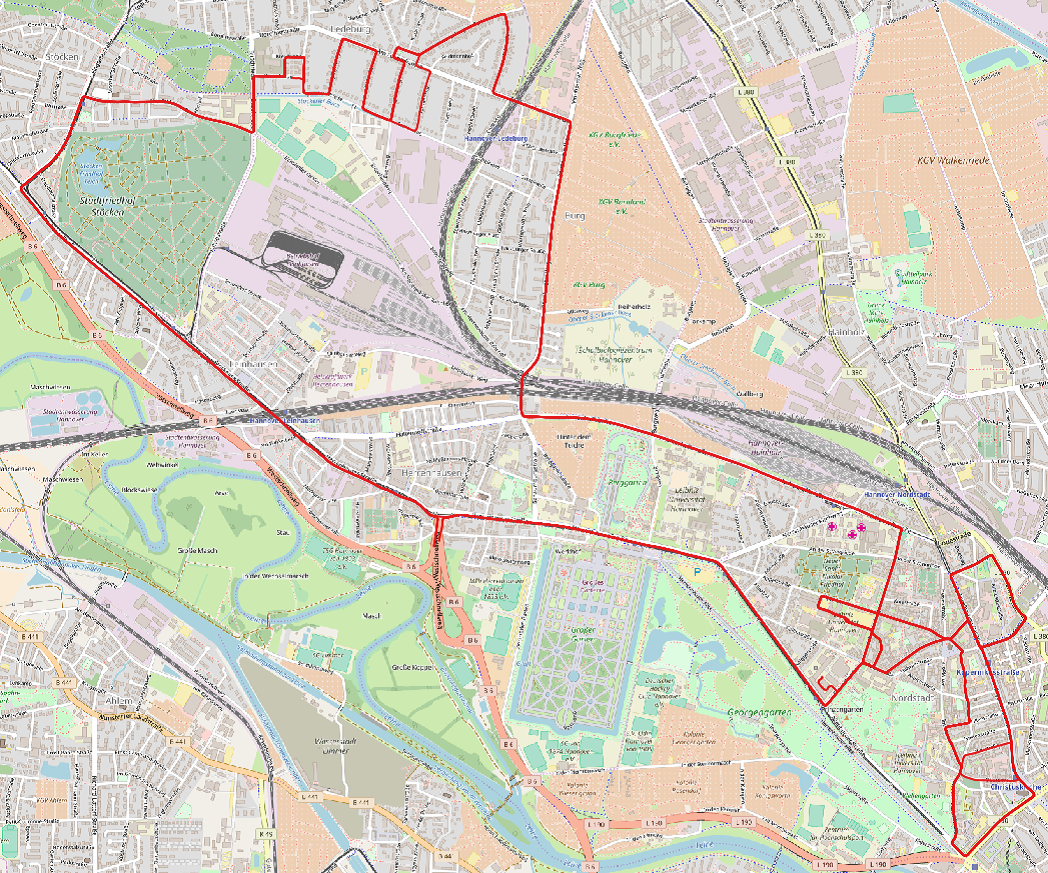

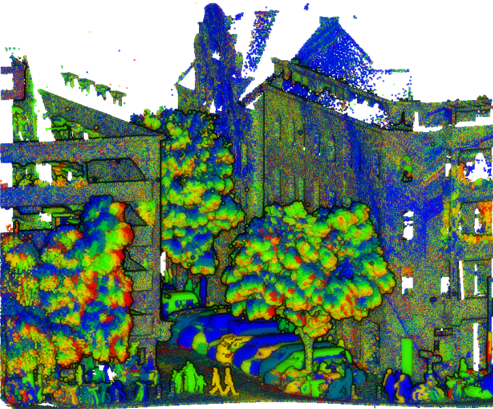

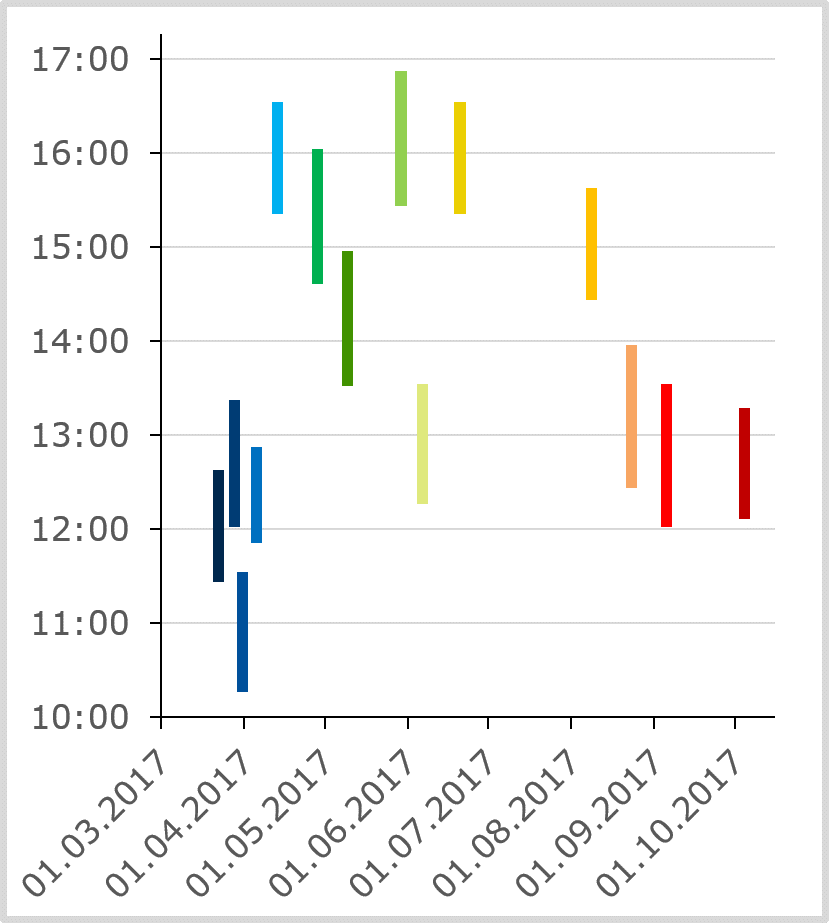

Für dieses Projekt wurde ein umfangreicher Langzeitdatensatz aufgenommen. Dafür haben wir etwa alle zwei Wochen (von März 2017 bis März 2018) Messkampagnen mit einem LiDAR Mobile Mapping System entlang einer ca. 20 km langen Strecke in Hannover durchgeführt (siehe Abb. 2). Die Route überschneidet sich teilweise mit dem Messgebiet der i.c.sens Mapathons und umfasst sowohl Innenstadtbereiche als auch Wohngebiete, verschiedene Straßenarten (einspurig, mehrspurig und mit Straßenbahnlinien), verschiedene Kreuzungen, Parkplätze, Gebiete mit hohem Fußgänger- und/ oder Fahrradverkehr. Der resultierende Datensatz umfasst alle verschiedenen Jahreszeiten (von der blattlosen Vegetation bis zur Vegetationsperiode usw.) sowie verschiedene Wetter- und Lichtverhältnisse (sonnig, bedeckter Himmel, Dämmerung, Dunkelheit und schneebedeckte Straßen). Abb. 3 zeigt Beispiele für die verschiedenen Messbedingungen.

Für die Datenerfassung wurde ein Riegl-VMX Mobile Mapping System (MMS) verwendet, welches, wie in Abb. 1 dargestellt, auf einem Messfahrzeug montiert war. Das MMS ist mit zwei Laserscannern vom Typ Riegl VQ-250 und vier Kameras ausgestattet. Die Lokalisierung geschieht über ein hochgenaues GNNS/INS-System, das mit einem Distanzmessgerät (DMI) kombiniert ist. Zusätzlich zur direkten Georeferenzierung wird eine kleinste Quadrate Ausgleichung der Messkampagnen durchgeführt, woraus sehr präzise angefelderte Punktwolken mit Milliarden von Punkten resultieren.

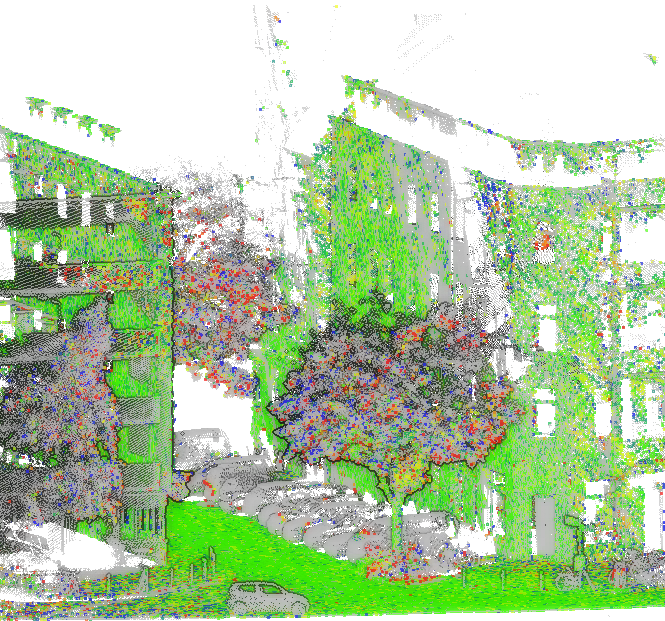

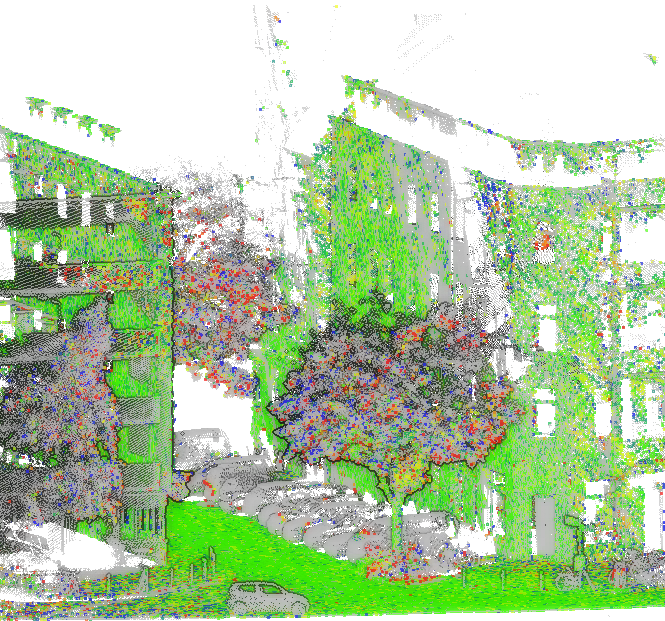

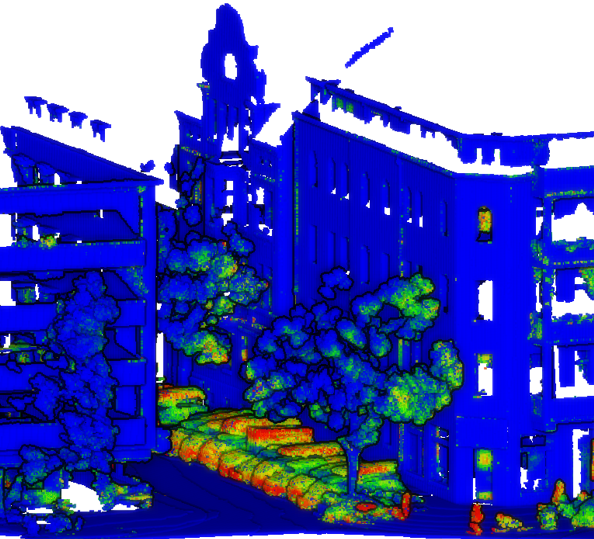

Dieses Projekt verwendet hauptsächlich LiDAR-Punktwolken, die prozessiert und ausgeglichen wurden. Abb. 4 zeigt eine Beispielpunktewolke, die Messungen aus 14 Messkampagnen enthält.

Bei unserem Umgebungsmodell haben wir uns für eine Rasterdarstellung (Voxel) entschieden. Da die ausgeglichenen Punktwolken in der Regel eine Standardabweichung von weniger als zwei Zentimetern aufweisen, können die Gitterzellen sehr klein sein. Im ersten Schritt werden die LiDAR-Punkte in das Voxelgitter übertragen. Dabei wird ein Ray Tracing durchgeführt, wodurch nicht nur die Zellen identifiziert werden, in welchen sich Messungen befinden, sondern auch solche, welche vom Strahl durchquert werden und die daher als unbelegt betrachtet werden können. Im Resultat erhält jedes Voxel eine Beobachtungssequenz mit einem Zustand für jede Messfahrt. Der Zustand kann „belegt“ (enthält einen Reflexionspunkt für diese Messung), „frei“ (kein Reflexionspunkt und von einem Laserstrahl durchquert) oder „unbekannt“ (keine Information) sein. Dieses Belegungsraster ist die Grundlage für unsere Karte.

Als erste und einfache Lösung für eine Referenzkarte haben wir für jedes Voxel einen Konfidenzmaß berechnet (Anzahl der freien/ Anzahl der besetzten Zustände in einer Sequenz), welches ein Maß dafür ist, ob das Voxel Teil eines statischen Objekts oder eher temporär/ dynamisch ist. Abb. 5 zeigt eine Beispielpunktwolke, die nach dem Konfidenzmaß eingefärbt ist. Blaue Punkte haben ein hohes Konfidenzmaß (statische Teile der Umgebung) und grün bis rot zeigt die dynamischen Punkte an.

Dieser Referenz-Ansatz hat den bereits erwähnten Nachteil, dass er zwar dynamische Objekte einschließt, deren Verhalten aber nicht modelliert. Die Likelihood einer Messung besteht aus zwei Komponenten: „Ist das gemessene Objekt vorhanden?“ (Voxel besetzt) und „Ist das Objekt sichtbar?“ (im Messbereich und nicht verdeckt). Diese beiden Kriterien hängen stark von der Objektklasse der gemessenen Punkte ab. So ist z.B. eine Fassade hinter einem Baum immer vorhanden, aber im Sommer wird sie sehr wahrscheinlich durch das Laub des Baumes vor der Fassade verdeckt (siehe die blauen Bereiche auf der rechten Fassade in Abb. 4).

Um diese beiden Faktoren zu berücksichtigen, verwenden wir ein Strahlmodell. Unsere Untersuchungen haben gezeigt, dass für die Lokalisierung eine Karte aus derselben Jahreszeit am besten funktioniert. Abb. 6 stellt das Beispielgebiet mit einer Voxelkarte (grau) aus einer Messfahrt Anfang Juni im Vergleich zu einer Punktwolke aus einem Testfahrt Ende Juni. Die gemessenen Punkte an den Fassaden liegen meist innerhalb der entsprechenden Voxel. Punkte auf Vegetation und geparkten Autos hatten einen größeren Abstand zum nächstgelegenen Voxel in der Karte oder es wurde kein korrespondierendes Voxel gefunden.

Das Lokalisierungsergebnis kann weiter verbessert werden, wenn die Karte aus mehreren Messfahrten zusammengesetzt wird. Dies hat jedoch den Nachteil, dass je mehr Informationen die Karte enthält, desto mehr weiter entfernte Korrespondenzen werden gefunden. Irgendwann kehrt sich der positive Effekt um, viele "schwache" Korrespondenzen werden in das Ergebnis aufgenommen und die Lokalisierung verschlechtert sich. Wir entwickeln derzeit ein Messmodell, das eine Gewichtung der korrespondierenden Voxel entlang des Strahls in Abhängigkeit von der in der Karte abgelegten Objektklasse enthält. Dazu verwenden wir Klassifikationsergebnisse aus Projekt 3 (semantische Segmentierung) und untersuchen das zeitliche Verhalten der einzelnen Objektklassen.